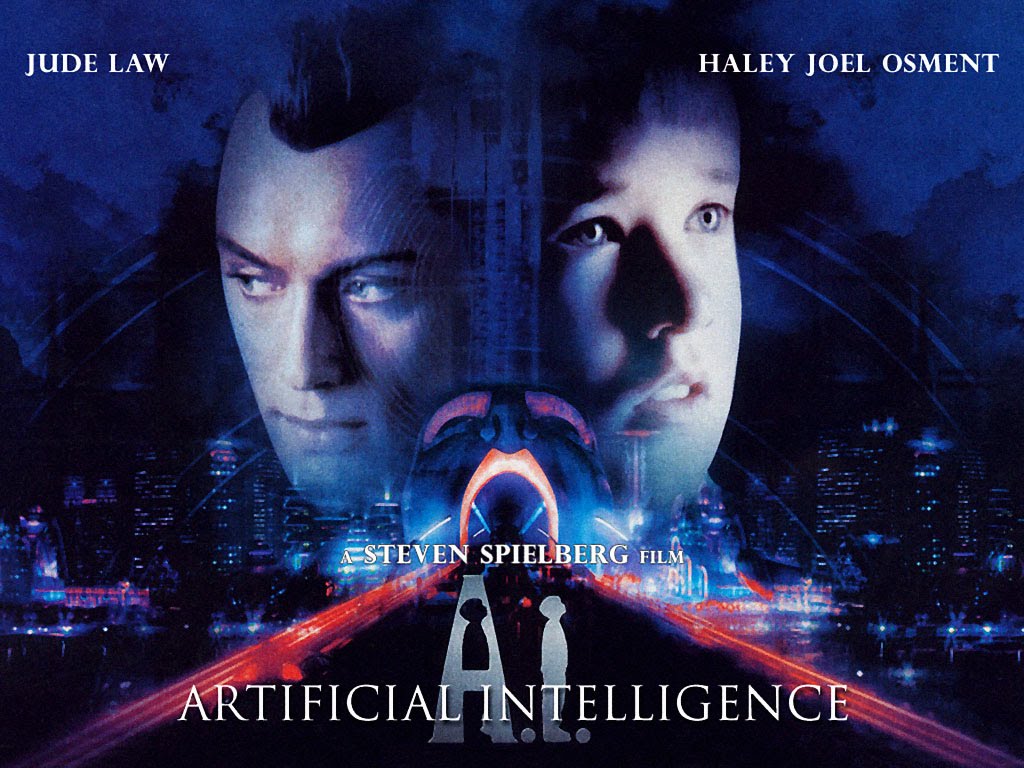

【影評】《A.I.人工智慧》&《模仿遊戲》:何謂自我?何謂真實?

逐漸發展出成熟人工智慧的人類,藉由電影、小說、文本揮灑著人類的想像,描繪出在後人類時代,身為萬物之靈的我們,該如何自處的觀點與逐漸對未來失去控制的焦慮。在電影《A.I.人工智慧》中,為人類未來描繪出了後末日的想像,在全球暖化後的社會,海平面的上升淹沒了現今仍富有繁榮的曼哈頓,會生老病死的人類也開發出了有感情、同時也超越人類極限的機器人,以彌補內心無法逾越的匱乏,同時卻又害怕機器人影響人類在社會上的生存地位,即秉持著造物主的傲慢,將機器人趕盡殺絕。在電影《模仿遊戲》中,則是回到人工智慧的發展剛伸出幼苗的二戰時期,藉由電腦之父圖靈的眼中,探討人工智慧是否有著思考的能力,以及為即將步入後人類時代的我們,了解人工智慧的起源。而兩部電影皆可以回溯到一個關於人工智慧最基本的核心命題:人工智慧是否會思考?何謂真實?何謂自我?

在電影《模仿遊戲》中,藉由圖靈的引領,走進了名為人工智慧的世界。在電影的某一個片段,圖靈被警探問到的一個問題「機器能像人一樣思考嗎?」,圖靈回答:「不,機器不能思考。然而,就因為機器不能像人一樣思考,就證明機器不會思考嗎?」人類往往害怕自己無法掌控又無法理解的事物,例如會思考的機器,害怕機器有一天會反噬人類的存在以及在這社會的重要性。又例如「同性戀」。在當時的年代(甚至是現代),社會並無法接受同性戀的存在,或許是因為不了解,又或許是因為不願意不想去接納不同的存在,當人類害怕某件事物時,總是會想辦法去摧毀它,因為解決提出問題的人遠比解決問題本身還要容易且省時許多。因此圖靈問道「我們究竟是人?還是機器?」我們常常自詡是萬物之靈,擁有著智慧的我們可以統御世間一切事物,但是自古以來卻一直無情地自相殘殺,納粹希特勒仍然殺了無數猶太人以及同志族群,破壞了許多人的家庭,在這個由人類組成的社會,明明應充滿著仁慈的光輝與人性的溫暖,卻仍然如同機器一般無情地吞噬這世界上與大多數不同的人。究竟是人,還是機器,仍然那麼重要嗎;去探究兩者之間的界線,去釐清何謂真實,何謂虛構,仍然那麼重要嗎?

後現代觀點的哲學家布希亞所提出的「超真實」觀點,當原本生活型態被「仿真體」(simulation)遮蓋並被佔據時,「原真實」已經被「超真實」(hyperreality)給覆蓋過去,而布希亞則舉了迪士尼樂園作為例子,說明作為擬仿物的迪士尼樂園逐漸取代了美國與美國夢,使得大家逐漸誤認迪士尼樂園即為美國夢,擬仿物對原真實產生了反噬。同理,在電影《A.I.人工智慧》前半段,導演史蒂芬史匹柏透過莫妮卡、其親生兒子馬丁、人工智慧機器人大衛之間的三方對話,淋漓盡致地發揮了布希亞的「超真實」觀點。莫妮卡的親生兒子馬丁對仿真體與真實的斷裂做出了詮釋:當馬丁拿著資本主義下大量生產的直升機對大衛說:「這種玩具要把它打破才比較有意思。」這不正是一種對原形不再懷舊的表現嗎?正是因為不再懷舊,才使得無限的生產得以可能,正是因為圓形的大量複製與製造,才使得每件物品皆成為了彼此的等價物,打破的並不僅僅是直升機的形體,而是真實與擬仿物之間的界線。

You don’t look like a toy, you are like an ordinary person.

大衛的媽媽莫妮卡則是一個誤認「超真實」為「真實」的案例。起初莫妮卡對於其丈夫亨利帶回具有感情與同理心的大衛回家藉此替代其瀕死的兒子馬丁的行為感到無法接受與理解,但隨著大衛的種種的行為,例如叫莫妮卡「媽咪」,以及種種渴望愛的行為,讓身為「仿真體」的大衛逐漸遮蓋並佔據了莫妮卡的「原真實」,使得「原真實」被「超真實」壓扁,對於本應是仿真的機器人產生了對人的感情,仿真體與真實間產生了斷裂,讓原本的真實更為真實,也因莫妮卡的同情心,使得馬丁得以脫離原本必須面臨機器人屠宰場命運。

另外,該如何從哲學觀點去判斷誰是人類、誰是機器人呢?我們可以在電影中發現一個有趣的現象:每個機器人都知道自己的存在意義,而且完全不為外在環境所動。被製造出來就是要滿足莫妮卡愛與隸屬需求的大衛,對於母愛的渴求貫穿了整部電影;裘德洛飾演的性̷愛̷愛情機器人即使在被誣陷殺人後,還是保有著極欲求愛的積極性(這是堪入耳的說法);在大衛準備要被抓到機器人屠宰場前碰到的保母機器人,無論受到什麼樣的威脅,還是告訴著大衛不要害怕,一切會好起來,仍善盡著自己身為保母機器人的職責。

這正說明了人類與機器人最關鍵的差異,也就是存在主義的基本命題:存在先於本質(Existence precedes essence)。沙特認為,人在一開始並沒有任何先天的本質,而關於我們自身的一切,例如地位、身份等皆是存在後才被賦予的,因此首先必須先肯定人的存在,再去賦予存在意義,並且甚至超越自己所創造的價值。對於一個人造物而言,在被製造之前,必定會先知道其用途所在。小學美勞課,我們必定都是在腦中對作品先有個雛形,接著再動手去創造。同理,這些機器人在被人類創造出來之前,必定是先有其目的與用途,接著才去製作這些機器人。

身為一個人,我們時時刻刻都在改變甚至超越著自我的本質,前一秒的你跟後一秒的你很可能就代表著截然不同的意義。但在電影《A.I.人工智慧》中的機器人卻始終無法在面對快速變化的世界隨時改變自我價值,還是不斷地重複著自我的使命,直到故障為止。相反地,在《銀翼殺手2049》中,殺手K卻是在劇情的推動之下,自己眼中的世界觀不斷地翻轉,甚至是對自我價值的挑戰,之後再寫一篇文章詳細介紹。

順帶一提,沙特也為「存在先於本質」一說做出結論,人會害怕在眼前的過多選擇中做出錯誤判斷,因而不願意為自己的選擇負責任。對此,沙特說,你是自由的(是不是聽起來很熟悉?),所以自己做出選擇吧,唯一要記得的就是要為自己的選擇負責。

話說回來,故事在大衛找到自己的造物主後,發現自己只不過是許多被創造出來的「眾多大衛中的其中一個大衛」,另一個用來滿足造物主的內心缺乏 - - 已故兒子的替代品罷了,此時的大衛已經無法在自我異化中認出自我,自我衝突與矛盾的大衛最終選擇了跳下被海水淹沒的曼哈頓,卻又在彌留之際,在水中看見了自己不斷尋找的藍仙子的雕像,於是此時的大衛,從「滿足人類情感需求的眾多大衛中的大衛」意識到自己仍然是那個「渴求莫妮卡母愛的大衛」,再次地在行動中認出自己。只是事與願違,虛構的童話終究是虛構,大衛也將虛擬的童話誤認成為真實,一心祈禱了兩千年,希望藍仙子可以讓他變成真正的人類。

諷刺地,過了兩千年之後,高度進化的人工智慧是存留在世上的唯一「生命」物種,人類早已自取滅絕。而這些人工智慧物種找到大衛並了解他的故事之後,透過時空軌跡以及仍保留在泰迪身上的莫妮卡的頭髮,藉由DNA以及時空代碼重現莫妮卡的樣貌與記憶。此時導演彷彿也暗示了人類的存在本身也是如同機器人一般,是藉由並不代表任何意義的代碼(人類:ATCG、機器人:二進位)所模擬的真實,因此布希亞也指出,人類當代社會已經不再是先有真實,接著擬仿物掩蓋了真實,而是先有擬仿物,而這些擬仿物建構了我們的真實。當真實可以藉由擬仿物不斷建構並複製,那麼真實還是真實嗎?又或者,擬仿物即是真實?

這些對於未來科技的想像,以及回頭看向過去的反省,人類可以透過文本的建構、哲學的探討,百花齊放的結果提醒了我們必須做好準備去迎向未來將會更迅速變化的差異性,並且以更開放的胸襟去接受這些與我們的不同。正因二戰時期的人類不願理解同志族群的權益,而痛失了可能讓人類社會向前一大步的電腦巨擘;正因我們對於自己所認知的機器人的不真實感到不信任,而錯過了與機器人共同和平相處的可能未來。或許,圖靈想要的只是安靜地一頭埋進自己感興趣的事物,並供他自由揮灑才華的空間;或許,大衛想要的只是自然地被人類所看待,愛人以及被愛,並且能與莫妮卡永遠在一起。就是因為這些種種的故事與想像,才得以讓即將跨入後人類時代的我們一管窺天地看向未來,並為即將到來的世界做好一切的準備。

後記:重弄了新的部落格,以及會有這篇文是因為這學期修了人工智慧導論,一開始老師就介紹了兩部他心目中最棒的人工智慧主題的電影,要我們回家寫心得。起初想說,還有什麼人工智慧相關的電影是我沒看過的,所以導致我一開始看A.I.人工智慧的時候還有點不耐煩,但看著看著卻想到了文學批評課上所學到的理論,就想說,不然來寫寫看好了!又討厭以前那個部落格,就弄了個新的,把舊的黑歷史刪掉。就這樣,也不知道會不會有下一篇,但應該不會再刪了哈哈哈。

2023/01/08 更新

這是大五上學期修的人工智慧導論的其中一份作業,有點掉書袋的影評,當時主要是想學超級歪那種文本分析的方法,很酷!結果被教授特別挑出來討論,說跨領域就是要這樣!

這門課讓我印象很深刻的是當時老師 demo 了一個推薦系統,結果發現那個推薦系統要 XP 的 IE 才能跑(也就是最新的 IE 也不行跑,更別提當時 IE 也已經苟延殘喘了)沒想表達什麼,只是覺得很酷。最近在整合過去到現在寫過的長文到這個個人網站,想說這篇也跟人工智慧還有影評有關,也符合這個部落格的主題,這篇才又被我翻出來,現在碩班的我再看…啊,真是掉書袋呀!